Mish: A Self Regularized Non-Monotonic Neural Activation Function

发布于 2021-02-19 13:27:31

一、 简介

在传统的任务中,下面两个激活函数被广泛应用:

ReLU(Rectified Linear Unit):

Swish:

其中ReLU经常被挑战,挑战者包括SQNL、ELU、PReLU等。但是由于Relu与Swish是非单调激活函数,并保持着有下界无上界的性质,因此被广泛使用。在部分任务中Swish效果更好,如ImageNet数据集的相关任务。

二、定义与性质

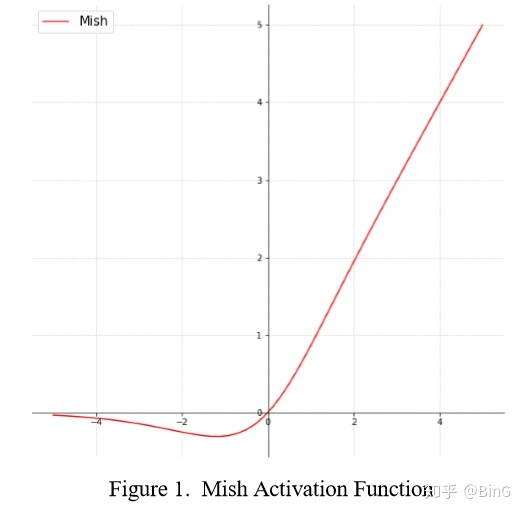

mish的定义: [公式]

(图片来自原文)

Mish也保持着有下界无上界的特性。它的范围大致在 [公式] 。

其导数为: [公式] 根据观察,Mish的最小值约为-0.30884,当 [公式] 时取得。

Mish在常用的深度学习框架中容易实现!

Mish有以下几个比较重要的性质:

| 性质 |

Order of Continuity | [公式]

Monotonic | No

Monotonic Derivative | No

Saturated | No

Approximates Identity at Origin | Yes

这些是使其性能优秀的主要原因。

三、实验

文中的实验主要用于MNIST数据集和CIFAR-10数据集。效果不错。在同样的计算框架下,可以对比得出以下结论,表示性能优越。

(图片来自原文)

可以看到,Mish的表现是优异的。还有其他结果对比,Mish均排名第一。这里不再过多展示,有兴趣的朋友可以阅读原文。

写在后面:

本文重在抛砖引玉。

虽然是抛砖引玉,但是这个Mish有兴趣的朋友还是可以尝试一下。

直接上传md文件时,公式会有问题,需要手动整理。

直接上传md文件时,md中的图片会有问题,需要手动整理。

仍旧建议使用md文件上传的形式,刚刚我的草稿丢了:(。可能跟网速有关!

后面请各位自由发挥,建议把序号弄好。

0人点赞

发表评论

分享

收藏

感谢

举报

0 条评论